作者:Morty Lai

2022年11月美國人工智慧研究公司OpenAI正式對外釋出ChatGPT,這款基於大型語言模型的生成式AI工具短短2個月就吸引全球上億用戶使用,不但使用者持續快速增加,相關延伸應用也越來越多元。不知道使用過GPT的你是否曾有過剛開始用都覺得很新奇、很方便,但是之後仔細一看才發現回答的內容會出現「一本正經的胡說八道」,如果再糾正系統,也只會回答「我很抱歉」,然後再看似正常地提供其它可能的錯誤答案的經驗呢?模型生成的結果中包含不真實或不存在的資訊就是幻覺 (Hallucinations),這可能讓使用者產生誤導性的結果或錯誤理解。特別是在網路輿情分析服務中,若分析結果經常產生幻覺,使用者可能會根據錯誤的資訊做出誤導性的判斷,進而對評估和決策產生負面影響。因此,了解和減少幻覺的產生,是建立自動化輿情分析服務必需面對的難題。

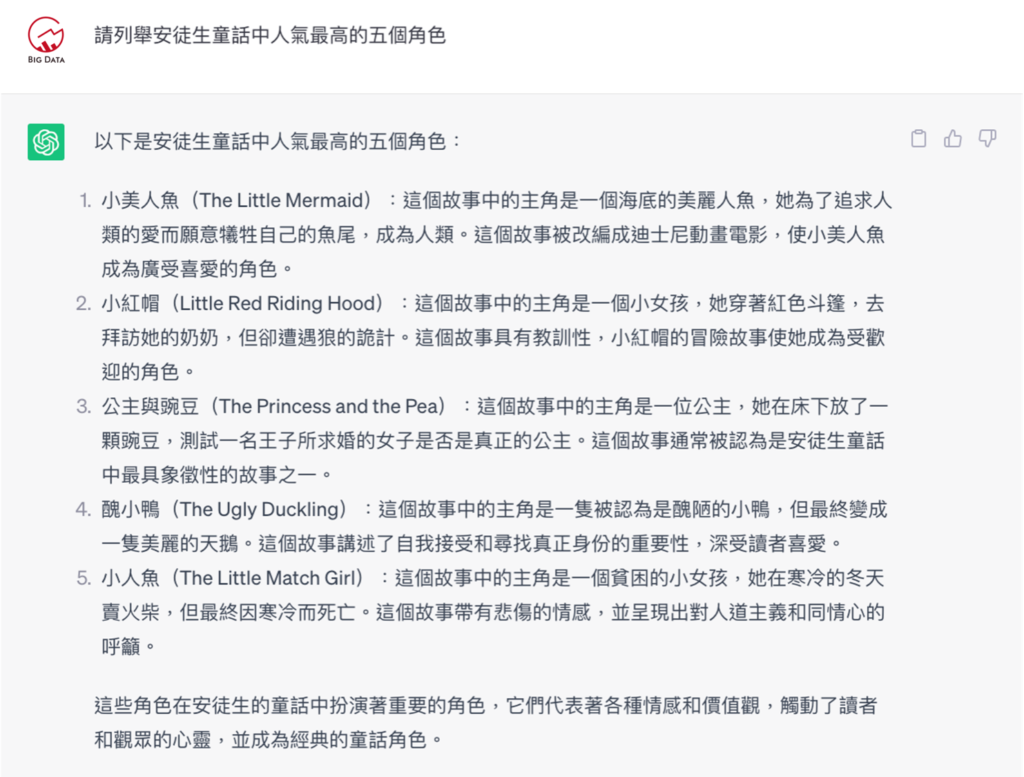

在大型語言模型的研究中,通常將幻覺分為內在幻覺 (Intrinsic hallucinations) 和外在幻覺(Extrinsic hallucinations) 等兩種類型。內在幻覺是指生成結果與提示內容 (prompt) 相互矛盾,而外在幻覺則是生成結果無法根據提示內容進行驗證,並提供了幻覺的實例與說明。不管是內在幻覺,抑或是外在幻覺,都有可能是模型根據相似性泛化出來,有可能是對的,有可能是錯的,還有可能根本沒辦法判斷對錯。目前許多文章探討發生幻覺的實例及需要注意的潛在風險,當用大型語言模型做摘要、翻譯或對幻覺容忍度較低的任務時,就需要做驗證。另外,若要提供自動化輿情分析服務,在開發過程需嘗試不同的設計與實驗,才能減少幻覺帶來的負面影響。舉例來說,向GPT詢問安徒生童話中人氣最高的五個角色這個問題(圖一),列舉出來的答案看起來都蠻道理,但事實上小紅帽是出自格林童話,公主與豌豆中在公主床下放豌豆的是國王與皇后,並非公主,小人魚應該叫賣火柴的小女孩。整體來說,嚴格說起來,GPT提供的5個例子都算是外在幻覺,其中「小人魚(The Little Match Girl)」算是內在幻覺。

再根據小紅帽的故事提供一段外在幻覺與內在幻覺的應用(圖二),因為提示內容有指出「獨居的外婆」,但GPT卻回答「小紅帽和她的外婆住在一起」,如此矛盾的答案,這句話是內在幻覺。同時,在詢問GPT看到什麼,回覆「她手中拿著一個籃子,裡面盛滿了食物和禮物」,由於這句話無法從提示內容驗證事實,不知道小紅帽到底有沒有帶伴手禮,這就是外在幻覺。儘管幻覺是一個受到重視的議題,但評估並非容易。許多研究BLEU、ROUGE和BERTScore等探索自動評估幻覺的指標,多數是從忠實性的角度出發,量化生成內容與參考答案之間的相似程度。儘管有許多量化指標被提出,但要精確評估幻覺的影響,仍需要結合專業知識和人工審查,因為人工審查才能更全面地評估生成內容是否具有忠實性,並達到預期目標,對生成內容的品質與可靠性進行全面且快速的評估。

為了提供更即時的第一手網路聲量洞察內容,讓原本需要數小時或數天的分析洞察過程縮短至數分鐘,《KEYPO大數據關鍵引擎》聚集了軟體工程人員、數據分析團隊和文案編輯等多方專業人員,共同合作設計、測試,並推出全台首創結合「ChatGPT 智能輿情分析」功能。跨領域合作打造具有即時性、準確性、清晰度和易讀性的報告生成功能,無論是企業、品牌還是公眾人物,都可以一鍵產出輿情分析報告,掌握即時洞察和應對網絡輿情的動態變化。

想了解更多全台首創結合「ChatGPT 智能輿情分析」的《 KEYPO 大數據關鍵引擎》輿情分析系統強大功能了嗎?請立即與我們聯絡以取得更多資訊。

Image by vecstock on Freepik