作者:Morty Lai

生成式大型語言模型(large language model,簡稱LLM)的強大能力,已經廣泛應用於知識問答、摘要生成、語意分析等相關服務,但對於生成內容的正確性,仍備受關注。雖然LLM是基於海量數據訓練而成,並能夠生成流暢且結構完善的文字內容,但這並不表示內容完全可靠。因此,在設計LLM的應用服務時,也必需設計相關的驗證機制,也就是說讓 AI 學會「反省」,幫自己檢查答案的正確性,才能減少這些似是而非的生成內容。

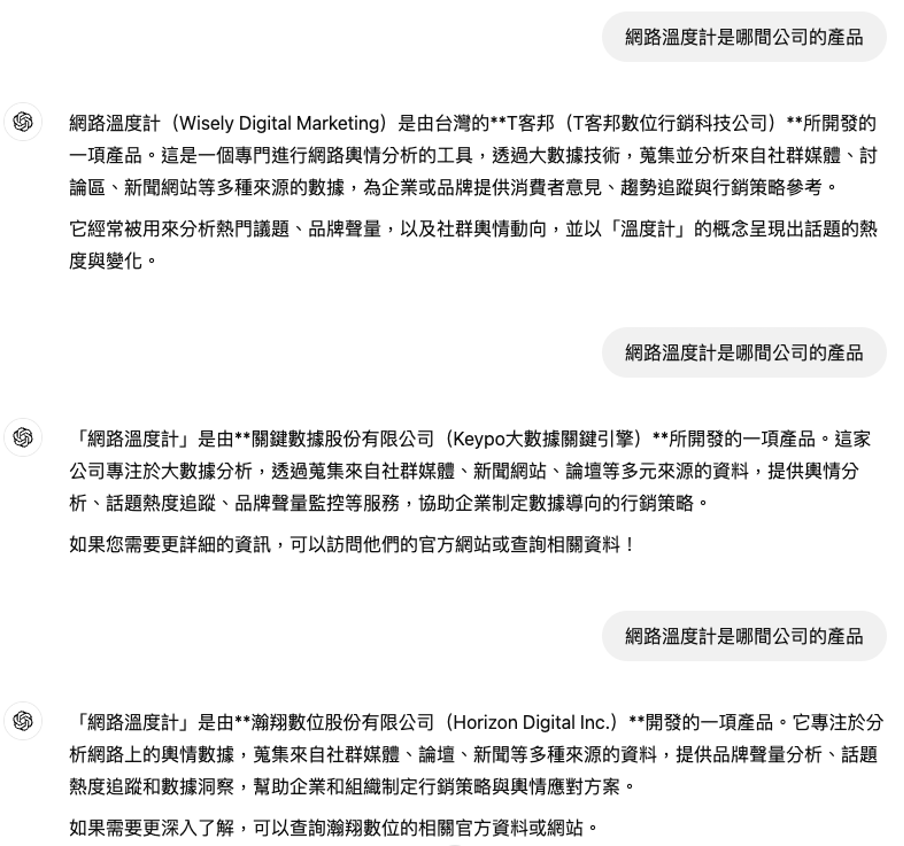

在設計驗證機制之前,可以將LLM的生成內容進行分類,並針對不同的類型設置相應的機制,進而強化生成內容的正確性。LLM生成的內容可簡約歸納為兩大類,分別是「知識提取」與「推理任務」。知識提取可以看做是從模型的訓練內容中提取資訊,以回答用戶的問題,例如,「網路溫度計的創辦人是誰?」、「KEYPO輿情系統要找誰購買?」。另一方面,推理任務要求模型基於已知條件進行邏輯推演,例如提供洞察意見、進行文章摘要或計算問題。因此,我們可以對於知識提取與推理任務,分別建立不同的自動化驗證機制。

對於知識提取任務,可以將相同的問題讓LLM生成多次的回應,再從這些回應中檢視其一致性。若LLM多次生成內容都不一樣,則意味著回性內容的可信度較低。這就像是一個人對於相同問題,每次回答都不一樣,會讓人難以採信此問題的回答結果。但是,考慮到每次回答都可能會有用字遣詞上的出入,故不能僅以文字比對進行一致性評斷,而是需要考慮語義之間的相似性。因此,可以運用BERTScore來檢視不同生成內容之間的語意一致性。透過對於多次生成內容一致性的檢測,則可以加強知識提取任務的正確性,並對於不確定性較高的生成內容另外處理,而不是直接提供似是而非的內容。

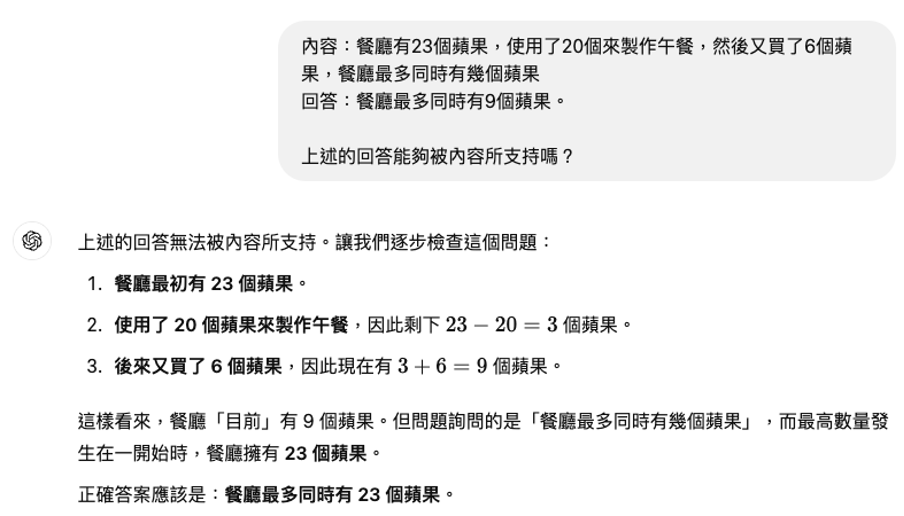

相較於知識提取任務,對於推理任務的生成內容,可以佐以提示內容來進行驗證。由於推理任務的生成內容與提示內容通常有著相當的因果關聯,所以生成內容也應該能從提示內容進行驗證,這就好比人類可以對於計算問題進行驗算,又或著是像閱讀測驗,可以檢視答案是否符合文意。因此,對於LLM的生成內容,我們可以整合生成內容與先前的提示內容,並再次詢問LLM生成結果是否能被提示內容所支持,藉此達到驗算的效果。舉例來說,「問題:餐廳有23個蘋果,使用了20個來製作午餐,然後又買了6個蘋果,餐廳最多同時有幾個蘋果?回答:9個。上述的回答能夠被內容所支持嗎?」。經由上述的驗算描述,LLM可以發現錯誤,並更正為正確的答案。因此,我們可以讓LLM再次進行驗證,藉此降低推理錯誤的可能性。

大數據股份有限公司所推出的一站式數據平台《KEYPO Suite》,所提供的《KEYPO大數據關鍵引擎》不只是一套輿情分析軟體,更是一個「負責」的AI輿情分析服務。在這充斥著以假亂真的資訊洪流中,《KEYPO Suite》運用多項的AI模型與軟體技術,幫助你還原真實的網路聲音,提供你快速且精確的洞察內容。同時,也包含《Fanti 人群輪廓分析》和《KEYDERS 網路意見領袖搜尋引擎》等服務,協助品牌輕鬆找到熱門話題、目標群體和合適的網紅,全方位解決行銷和商情管理的需求。

想了解更多一站式數據科技平台《KEYPO Suite》強大功能了嗎?請立即與我們聯絡以取得更多資訊。