現在很多人用 AI 聊天機器人來查資料、問問題,像是ChatGPT這類大型語言模型(Large Language Model,LLM),已經變成很常見的工具。不管是想了解健康資訊、找資料、還是幫忙整理報告,它都能快速給出看起來很專業的答案,大大提升我們找資料的效率。不過問題來了,AI講的內容,真的都對嗎?因為AI回答的範圍太廣,有時候會講錯或是「看起來很合理但其實是假的資訊」。為了改善這問題,有些系統會把AI接上外部資料庫(Retrieval-Augmented Generation,RAG),讓它參考更多資料來源,幫助它回答得更準確。但即使這樣,AI還是有可能理解錯內容、或是把資料搞混。因此,現在研究人員和開發者正努力找出一種更通用、有效的方式,幫AI自動檢查自己說的話對不對,這已經成為發展AI的重要方向。

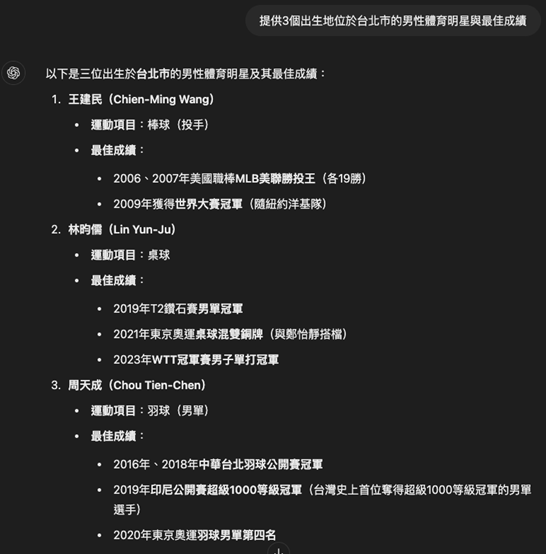

為了讓 AI 輸出的內容更可信,有一個實用的方法,就是讓它根據自己說的話,再產生一組「驗證問題」來檢查內容對不對。這就像是它講完一段話後,再回頭檢查自己有沒有講錯。比方說,有人問 AI:「請提供三位出生在台北市的男性體育明星,並列出他們的最佳成績。」AI 回答的內容可能是:王建民在 2006 和 2007 年拿下美國職棒 MLB 美聯的勝投王;林昀儒在 2023 年奪得 WTT 冠軍賽男子單打冠軍;周天成在 2020 年東京奧運羽球男單項目拿下第四名。這些答案看起來很合理,但我們怎麼知道它們是不是真的?

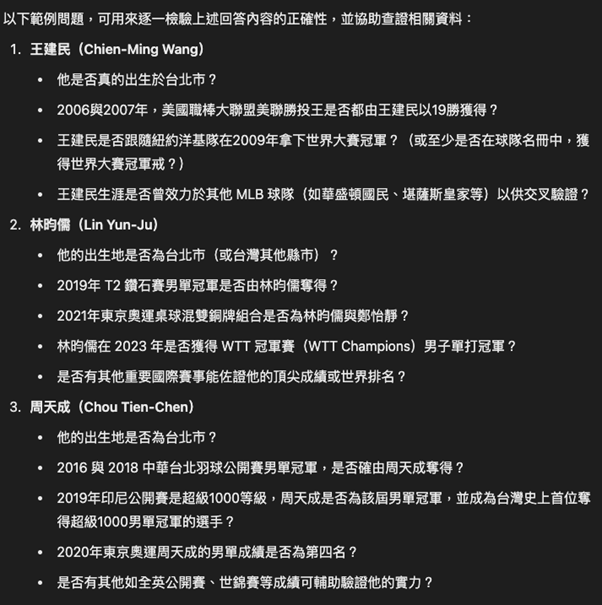

這時候,我們可以請 AI 根據自己的回答,再反過來提出幾個問題來驗證內容的正確性。它可能會問:「王建民真的出生在台北市嗎?」「林昀儒真的在 2023 年拿下 WTT 冠軍嗎?」「周天成當年奧運的名次是不是第四名?」這些問題就是所謂的「驗證問題」,是從原本的答案中拆解出來,用來逐一查證裡面的每一項關鍵資訊。透過這樣的方式,我們可以把原始問題和 AI 的回答當作提示,再讓它自己動腦產出相關的查核問題,並嘗試回答。這等於是讓 AI 幫自己複查一次,進而提高整體回答的正確性和可信度。

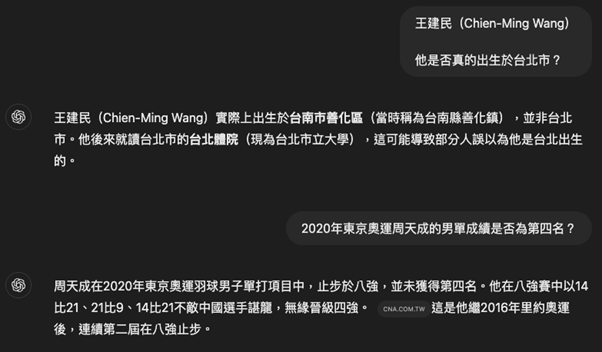

當 AI 產生出驗證問題之後,接著再讓它自己回答這些問題,其實能大幅提升整體內容的準確度。因為 AI 在回答原始問題時,可能會提供很多不同面向的資訊,而透過這種「先回答、再檢查」的流程,我們就能更清楚知道哪些部分是正確的、哪些需要修正,甚至哪些是完全錯誤的。舉個例子來說,如果原本 AI 告訴我們王建民是出生在台北市,但當我們再問它:「王建民真的出生在台北市嗎?」AI 卻回答:「王建民實際上出生於台南市善化區」,那就代表原本的回答是錯的。相反地,如果我們驗證周天成的出生地,AI 回答:「是的,周天成出生於台北市」,這就表示原來的資訊是正確的。不過也有可能出現資訊「有一點對,但又不完全正確」的情況。像是當 AI 原本說周天成在 2020 年東京奧運拿下羽球男單第四名,但後來又自己說他當年其實止步於八強,那就代表它的回答只能算部分正確。

透過這樣的驗證機制,AI 就像是在幫自己做校正,能夠自動排除錯誤的內容,也能調整那些講得不夠精確的部分,最終提供給使用者一個更正確、也更值得信賴的答案。這樣的設計,對於提升 AI 智能問答的可靠性來說,是一大進步。

《KEYPO Suite》所提供的《KEYPO大數據關鍵引擎》不只是一套用來分析網路輿情軟體,更像是一位幫你把關資訊真假的 AI 幫手。在這個假新聞、網路謠言滿天飛的時代,《KEYPO大數據關鍵引擎》結合多種人工智慧技術與演算法,幫助你從複雜的聲量中找出真正可靠的資訊,讓你更快、更準確地掌握網路上的真實聲音。這套由大數據(股)公司推出的一站式數據平台,除了能看見輿情的變化,並能幫你了解你的目標族群是誰、關注什麼,以及輕鬆找到適合合作的網紅或社群領袖。不管你是要經營品牌、行銷推廣,還是掌握市場脈動,都能透過《KEYPO Suite》一次搞定。

想了解更多一站式數據科技平台《KEYPO Suite》強大功能了嗎?請立即與我們聯絡以取得更多資訊。